Florian Fisch

22. November 2025

12 Minuten

AI-Washing: Warum Marketing-Psychologie 2025 im Enterprise-Software-Markt wichtiger ist als technische Substanz

Der europäische B2B-Technologiemarkt basiert auf einem Paradox. Executive Teams stehen unter Druck, KI einzuführen – doch fehlt oft die technische Grundlage, echte KI von clever gebranndetem Automatisierung zu unterscheiden. Wie Marketing-Psychologie technische Substanz schlägt.

AI-Washing: Warum Marketing-Psychologie 2025 im Enterprise-Software-Markt wichtiger ist als technische Substanz

Von Florian Fisch — November 2025

Der europäische B2B-Technologiemarkt basiert auf einem Paradox, das kaum jemand ansprechen will. Führungsteams stehen unter massivem Druck, künstliche Intelligenz einzuführen – sie gründen „KI-Ausschüsse" und „Arbeitskreise" mit zunehmender Dringlichkeit – doch dieselben Entscheider verfügen oft nicht über die technische Grundlage, um echte KI von clever gebranndetem Automatisierung zu unterscheiden.

Diese Wissenslücke hat eine lukrative Marktverzerrung geschaffen. Was Regulatoren und Forscher heute als „AI-Washing" bezeichnen – die Praxis, simple Automatisierung als „KI-powered" zu labeln – funktioniert nicht durch überlegene Technologie, sondern durch ausgefeilte Ausnutzung psychologischer Schwachstellen. Die Anbieter, die Marktanteile gewinnen, verstehen kognitive Verzerrungen besser als Machine Learning.

Wenn Druck auf Inkompetenz trifft: Das Gremien-Paradox

Enterprise-Beschaffungsausschüsse stehen vor widersprüchlichen Vorgaben. Sie müssen KI-Einkaufsentscheidungen schnell treffen, um Vorstände und Wettbewerbsdruck zufriedenzustellen. Gleichzeitig fehlt ihnen die Expertise, die komplexen Technologien zu bewerten, die sie beschaffen.

Diese Spannung erzeugt akute kognitive Dissonanz. Ausschussmitglieder glauben, sie sollten Innovationsführer sein, die Transformation vorantreiben. Gleichzeitig erkennen sie, dass sie die zugrundeliegende Technologie nicht verstehen, die sie bewerten. Dieses Unbehagen verändert die Entscheidungsfindung fundamental.

Das Ziel verschiebt sich vom Finden optimaler Technologie zum Finden vertretbarer Lösungen, die „die KI-Box abhaken" bei minimalem Risiko. Diese defensive Haltung macht Gremien systematisch anfällig für AI-Washing-Produkte, die sofortigen Wert ohne organisatorische Disruption versprechen.

Wie Wiederholung zur Wahrheit wird: Der Illusory Truth Effect

In Umgebungen voller Unsicherheit setzen sich Anbieter mit überlegenem Marketing konsequent gegen Anbieter mit überlegener Technologie durch. Der Mechanismus ist gut dokumentiert: der Illusory Truth Effect. Wiederholte Konfrontation mit Aussagen erhöht die wahrgenommene Richtigkeit – unabhängig von der Wahrheit.

Wenn Gremien auf „KI-powered", „intelligente Automatisierung" und „Machine Learning" in Webinaren, Case Studies, LinkedIn-Posts und Analystenberichten stoßen, entwickelt ihr Gehirn Processing Fluency. Die Behauptungen fühlen sich vertraut an. Vertraute Informationen werden leicht verarbeitet. Einfache Verarbeitung wird unbewusst als Wahrheit interpretiert.

Dieser Effekt bleibt bestehen, selbst wenn Menschen Behauptungen anfangs als fragwürdig erkannten. AI-Washing-Anbieter vermarkten nicht nur Produkte – sie formen kognitive Landschaften um. Durch koordinierte Wiederholung etablieren sie grundlegende „Wahrheiten", die schwer zu erschüttern sind, selbst mit überlegenen Beweisen.

Echte KI-Anbieter stehen vor einem massiven Nachteil. Sie argumentieren nicht von neutralem Boden aus. Sie versuchen, etablierte Überzeugungen zu verdrängen, die sich durch den Illusory Truth Effect bereits wahr anfühlen.

Relief verkaufen, nicht Software

Erfolgreiche AI-Washing-Anbieter verstehen etwas Entscheidendes: Ängstliche Gremien kaufen keine Enterprise-Software. Sie kaufen psychologische Entlastung von Entscheidungsangst.

Die effektivsten AI-Washing-Produkte teilen vorhersehbare Eigenschaften:

Sofortige Verständlichkeit: Die Logik muss in initialen Demos erfassbar sein. Komplexe technische Erklärungen über neuronale Netze oder semantische Modelle triggern Angst statt Vertrauen. Regelbasierte Systeme, die als „KI" gelabelt sind, funktionieren, weil ihre Wenn-Dann-Logik sich sicher anfühlt – auch wenn sie nicht intelligent ist.

Minimale Disruption: Lösungen müssen sich ohne Workflow-Redesign integrieren. Systeme, die extensive Änderungen erfordern, führen zu neuer Angst. Simple Automatisierung, die sich über APIs auf bestehende Prozesse auflegt, fühlt sich vertretbar an.

Quantifizierbare Metriken: Produkte müssen Zahlen für Leadership-Präsentationen generieren. Selbst bescheidene Effizienzgewinne werden wertvoll, wenn sie als „KI-driven Innovation" quantifiziert werden.

Diese Dynamik dreht sich nicht um Technologiequalität. Es geht um emotionalen Komfort. Der Anbieter, der Angst am effektivsten reduziert, gewinnt – egal ob seine „KI" echtes Machine Learning oder semantisches Verständnis involviert.

Täuschung erkennen: Gängige AI-Washing-Muster

Effektives AI-Washing folgt vorhersehbaren Mustern. Diese zu verstehen hilft, echte Fähigkeiten zu identifizieren:

Vage Versprechen ohne Verbindung zu tatsächlichen Fähigkeiten

AI-Washing setzt auf Buzzwords ohne technische Präzision. Begriffe wie „KI-enhanced", „intelligent" und „kognitiv" erscheinen ohne Erklärung von Modellen, Trainingsmethoden oder Architekturen. Echte KI-Anbieter liefern technische Details über Transformer, Trainingsdaten und Performance-Benchmarks.

KI als Feature, nicht als fundamentale Architektur

AI-Washing positioniert Intelligenz als modularen Add-on statt als fundamentales Systemdesign. Marketing betont, dass KI konventionelle Workflows „verbessert". Echte künstliche Intelligenz repräsentiert andere architektonische Paradigmen, bei denen Lernen Kern der Operations ist, kein Checkbox-Feature.

Fehlende Lernmechanismen

Echte KI verbessert sich durch Erfahrung. AI-Washing-Produkte vermeiden es zu diskutieren, wie Systeme lernen, welche Daten sie nutzen oder wie Genauigkeit sich im Laufe der Zeit verbessert. Wenn Anbieter Lernmechanismen nicht erklären können, haben sie wahrscheinlich keine außer manuellen Updates.

Keyword-Matching getarnt als Verständnis

Viele „KI-powered"-Systeme setzen auf ausgefeilte boolesche Logik und Keyword-Matching – wertvolle Techniken, die Jahrzehnte vor moderner KI entwickelt wurden. Echte KI demonstriert semantisches Verständnis: Kontext erfassen, Mehrdeutigkeit handhaben, konzeptuelle Beziehungen jenseits exakter Matches verarbeiten.

Die technische Trennlinie: Regeln vs. Lernen

Der fundamentale Unterschied reduziert sich auf eine kritische Frage: Verbessert sich das System autonom durch Datenerfahrung oder führt es vorgegebene Regeln aus?

Regelbasierte Automatisierung folgt expliziten Entwickleranweisungen. Diese Systeme können mit komplexen Decision Trees ausgeklügelt sein, aber sie können nicht lernen. Sie können unvorhergesehenen Situationen nicht begegnen und neuartige Antworten entwickeln.

Machine Learning entwickelt Entscheidungsmuster aus Trainingsdaten. Diese Systeme identifizieren Beziehungen, die Programmierer übersehen könnten, verbessern Genauigkeit mit zusätzlichen Beispielen und passen sich an evolvierende Muster ohne explizite Neuprogrammierung an.

Beide Ansätze haben legitime Anwendungsfälle. Das Problem entsteht, wenn Anbieter diese Unterscheidung bewusst verwischen und regelbasierte Automatisierung als „künstliche Intelligenz" vermarkten, um Premium-Positionierung zu erobern, die echtem Machine Learning vorbehalten ist.

Warum überlegene Technologie Beschaffungsschlachten verliert

Wenn echte KI bessere Langzeit-Fähigkeiten liefert, warum verliert sie dann in kompetitiver Beschaffung? Die Antwort liegt in denselben psychologischen Schwachstellen, die AI-Washing effektiv machen:

Komplexitätsstrafe: Echte KI-Architektur zu erklären – Transformer, Attention Mechanisms, Semantic Embeddings – erfordert Tiefe, die Gremien-Angst triggert. Größere Sophistikation macht souveräne Bewertung schwieriger.

Disruptions-Anforderungen: Echte KI erfordert oft organisatorischen Wandel. Workflows müssen neu designed werden. Personal muss upgeskillt werden. Diese Anforderungen fühlen sich riskant an für Gremien, die sichere, inkrementelle Verbesserungen suchen.

Verlängerte Value-Realisierung: Echte KI braucht Trainingsperioden, Integrationsphasen und Verfeinerungs-Zyklen. AI-Washing-Automatisierung demonstriert sofortige Verbesserungen in Anbieter-Demos, selbst wenn diese Gains fundamentale Limitationen haben.

Höhere Investment-Schwellen: Echte KI zu bauen erfordert substanzielles R&D in Data-Science-Talent und Compute-Infrastruktur, was sich in höherem Pricing niederschlägt. Budget-gepresste Gremien gravitieren zu günstigeren Alternativen, die in Präsentationen vergleichbar erscheinen.

Die kumulativen Kosten kurzfristigen Komforts

Organisationen, die AI-Washing-Lösungen wählen, sehen sich mit kumulativen Nachteilen konfrontiert, während Märkte reifen:

Genauigkeits-Plateaus: Regelbasierte Systeme erreichen schnell harte Performance-Grenzen. Sie können sich nicht über programmierte Regeln hinaus verbessern. Während Datenkomplexität wächst und Edge Cases sich multiplizieren, stagniert oder sinkt Genauigkeit.

Eskalierende Wartungslast: Jedes neue Szenario erfordert manuelle Regelerstellung. Was straightforward erscheint, wird zu wachsender Technical Debt – Exception Handling, Special-Case-Programmierung und fragile Logik, die unvorhersehbar bricht.

Wettbewerbsobsoleszenz: Organisationen, die in echte KI investieren, akkumulieren Vorteile durch kontinuierliches Lernen. Ihre Systeme verbessern sich automatisch, während regelbasierte Wettbewerber statisch bleiben – es entstehen sich weitende Performance-Gaps.

Krisengetriebene Migration: Letztendlich erzwingen akkumulierte Limitationen teure Emergency-Migrationen zu echten KI-Plattformen – unter Krisenbedingungen statt strategischer Planung.

Ein technisches Framework zur Bewertung

Mehrere spezifische Fragen schneiden durch Marketing-Rhetorik und identifizieren echte Fähigkeiten:

„Erklären Sie Ihren Lernmechanismus technisch detailliert." Echte Anbieter artikulieren spezifische Ansätze – neuronale Architekturen, Transformer-Modelle, Training-Pipelines. Vage Antworten oder „proprietäre Algorithmen" ohne Specifics indizieren regelbasierte Systeme.

„Wie verbessert sich Performance autonom durch operativen Einsatz?" Wenn Antworten manuelle Updates oder Entwickler-Intervention involvieren statt kontinuierlichem Lernen aus Production-Daten, fehlt dem System echte KI.

„Was passiert mit neuartigen Input-Szenarien, die nicht in Trainingsdaten vorkommen?" Echte KI generalisiert gelernte Muster auf neue Situationen. Regelbasierte Systeme versagen bei wahrhaft neuartigen Inputs oder erfordern Notfall-Entwickler-Intervention.

„Können Sie technische Architektur-Dokumentation teilen?" Transparenz über Modelldesign, Trainingsmethoden und Benchmarks indiziert Vertrauen. AI-Washing-Anbieter claimen breiten „proprietären Schutz", um Scrutiny zu vermeiden.

„Welche Trainingsdaten nutzen Sie und wie stellen Sie Qualität sicher?" Echte KI erfordert substanzielle, kontinuierlich aktualisierte Qualitätsdaten. Anbieter, die Datenstrategie nicht diskutieren können, betreiben wahrscheinlich kein echtes Machine Learning.

Wie Marktkräfte letztlich Wahrheit offenbaren

Marktmechanismen werden AI-Washing enttarnen, obwohl Timelines von Käufer-Sophistikation und regulatorischer Intervention abhängen:

Unabhängige Benchmarks: Während Third-Party-Testing-Frameworks sich entwickeln, werden objektive Performance-Unterschiede quantifizierbar und unbestreitbar.

Sophistikierte Käufer-Adoption: Wenn Data Scientists Procurement beitreten, identifizieren sie AI-Washing schnell durch technisches Questioning.

Wettbewerbs-Case-Studies: Organisationen, die in echte KI investierten, demonstrieren messbare Vorteile, die AI-Washing nicht replizieren kann.

Regulatorisches Scrutiny: Behörden untersuchen zunehmend irreführende Claims, besonders in regulierten Domänen wie Employment, Healthcare und Financial Services.

Die Herausforderung für echte KI-Anbieter ist, die Interimsperiode zu überleben, während diese Korrekturen Momentum entwickeln.

Organisatorische Immunität gegen AI-Washing aufbauen

Organisationen, die Wettbewerbsvorteile ernst nehmen, können Praktiken implementieren, die Manipulation widerstehen:

Technische Experten früh einbeziehen: Machine-Learning-Spezialisten inkludieren, die detaillierte Claims evaluieren können, nicht nur Business-Stakeholder, die für Marketing-Psychologie anfällig sind.

Demos mit echten eigenen Daten fordern: Lösungen mit messy, real-world Daten testen, die Edge Cases enthalten – nicht kuratierte Vendor-Datasets.

Transparente Performance-Dokumentation verlangen: Nach spezifischen Genauigkeitsmetriken nach Datentyp, Error Rates, Failure Modes und Benchmarks fragen. Echte Anbieter liefern detaillierte Dokumentation; AI-Washing-Anbieter lenken zu Testimonials ab.

Learning-Benchmarks über Zeit etablieren: Testen, ob Systeme sich tatsächlich verbessern, durch Genauigkeitsvergleiche über Wochen oder Monate Nutzung statt Anbieter-Claims zu akzeptieren.

„Quick Win"-Druck widerstehen: Wenn Lösungen verdächtig leicht zu verstehen erscheinen verglichen mit Alternativen, prüfen, ob sie echte Intelligenz repräsentieren oder gut vermarktete Automatisierung.

Der Weg nach vorne: Echte Innovation belohnen

AI-Washing reflektiert eine temporäre aber kostspielige Marktineffizienz, bei der Informationsasymmetrie Marketing erlaubt, technische Substanz zu dominieren. Dieses Ungleichgewicht korrigiert sich, aber das Tempo hängt von Käufer-Sophistikation und Vendor-Transparenz ab.

Damit das Technologie-Ökosystem zu gesundem Wettbewerb reift, der echte Innovation belohnt, müssen mehrere Shifts beschleunigen:

Technische Literacy: Entscheider brauchen grundlegende KI-Bildung – nicht um Praktiker zu werden, sondern um informierte Fragen zu stellen, die AI-Washing entlarven.

Ehrliches Positioning: Anbieter, die wertvolle Automatisierung bieten, sollten akkurat vermarkten statt KI-Terminologie für unverdienten Premium-Positionierung zu appropriieren.

Performance-Standards: Branchenverbände und Regulatoren sollten klare Definitionen und unabhängige Testing-Frameworks etablieren, die Accountability schaffen.

Langfristiges Denken: Organisationen müssen Anbieter belohnen, die echte Capabilities durch geduldige Partnerschaften aufbauen, statt zu psychologisch komfortablen aber technisch limitierten Quick Wins zu defaulten.

Der aktuelle Markt favorisiert unverhältnismäßig Anbieter, die kognitive Biases besser verstehen als neuronale Netze. Während Käufer Immunität gegen psychologische Taktiken durch Bildung und Erfahrung entwickeln, wird sich Wettbewerbsvorteil zurück zu Organisationen shiften, die genuinely intelligente Systeme bauen, die nachhaltige Verbesserungen liefern.

Die kritische Frage für die Industrie: Wie viel organisatorischer Wert und Wettbewerbschance wird auf AI-Washing verschwendet werden, bevor diese Markttransition komplett ist?

Florian Fisch analysiert Enterprise-Software-Märkte mit Spezialisierung auf künstliche Intelligenz, Machine-Learning-Systeme und B2B-Technologie-Adoptionsmuster. Seine Forschung fokussiert auf Recruiting-Technologie-Dynamiken, semantische Verständnissysteme und Procurement-Verhalten in der DACH-Region. Er berät Technologieunternehmen beim Positioning echter KI-Capabilities in Märkten, die mit AI-Washing-Claims gesättigt sind.

Related Blogs

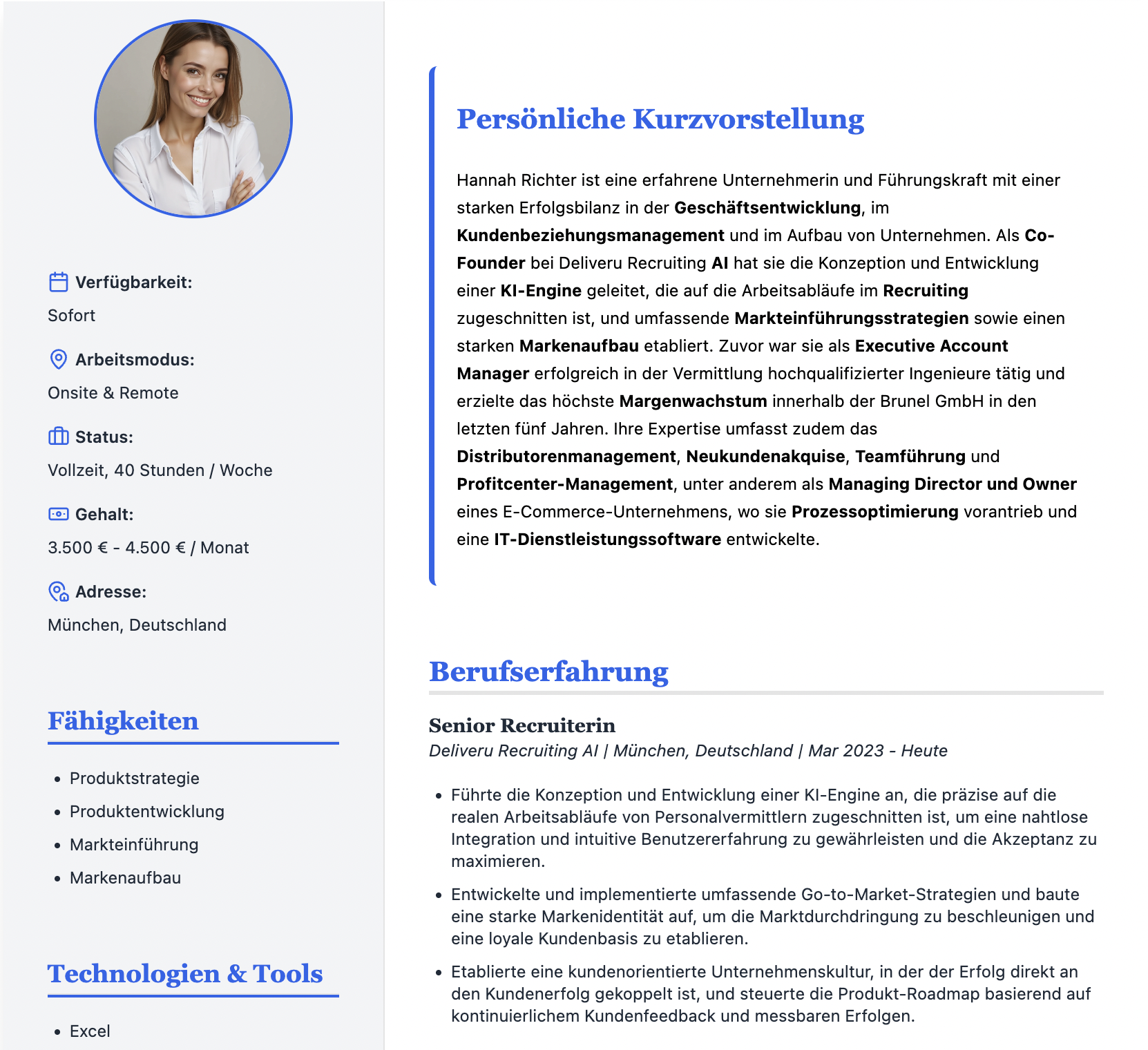

Florian Fisch

15. Oktober 2025

Jenseits des Parsings: Unsere Hyper-Extraktions-Engine erklärt

Traditionelle Parser liefern nur eine flache Liste von Schlüsselwörtern. Unsere Hyper-Extraktions-Engine schafft intelligente, sofort nutzbare Daten-Assets mit Multi-Agenten-System und KI-Anreicherung.

Florian Fisch

18. Oktober 2025

Warum Ihr ATS ein schlafendes Kapital ist

Ihr ATS ist wahrscheinlich voller unstrukturierter Daten, die es unmöglich machen, die besten Kandidaten zu finden. Die Lösung besteht darin, dieses schlafende Kapital mit intelligenter Technologie zu wecken.

Florian Fisch

23. Oktober 2025

Provisions-Sicherheit: Die Kunst des perfekten Blindprofils mit KI

Die manuelle Erstellung von Blindprofilen ist ein fehleranfälliger Zeitfresser. Mit Ein-Klick-Anonymisierung wird diese administrative Last zu einer strategischen Waffe für die proaktive Neukundengewinnung.

Echte KI statt Marketing-Buzzwords.

Keine vagen Versprechen, keine Keyword-Systeme aus den 90ern. Erleben Sie, wie echte künstliche Intelligenz mit semantischem Verständnis und kontinuierlichem Lernen Recruiting transformiert.

Demo vereinbaren